方班前沿秀第三十八期:香港科技大学(广州)陈雷教授做关于“数据科学用于AI和AI用于数据科学“的主题报告

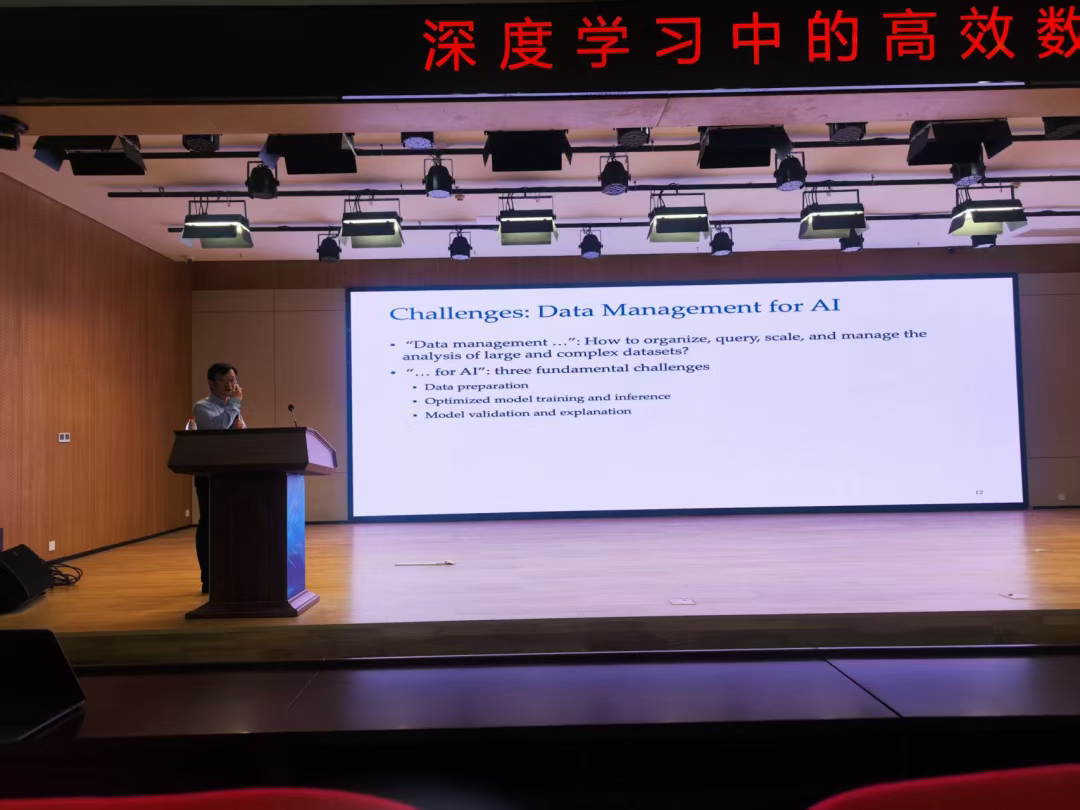

2025年10月23日,广州大学网络空间安全学院“方滨兴院士班”(方班)2025级的学子们齐聚广州大学黄埔校区B1栋109报告厅,迎来了本学期的第三十八期方班前沿秀。本次报告邀请到了数据处理领域专家、ACM和IEEE会士、香港科技大学(广州)陈雷教授作为主讲嘉宾,以“Data Science for AI and AI for Data Science”为主题,为在场的学子们带来了一场深入浅出、精彩纷呈的学术盛宴。

报告整体围绕“深度学习中的高效数据预处理”为核心,结合大模型时代背景,对数据预处理的技术挑战、优化方法及实际应用展开讨论,强调大模型与小模型的核心差异——大模型参数量大、能处理多模态数据并完成多任务,像模拟医护通过体温、心跳及对话判断病人病情并分配专科,而小模型仅专注单一任务,如用线性回归预测心跳血压。同时指出,当前大模型发展中算法不缺,如NeurIPS每年3万篇投稿,但最缺高质量真数据,且专用大模型训练时,大量时间耗费在数据清洗、整理等预处理环节,而非模型训练本身。

接着,陈教授分析了深度学习中数据预处理的核心技术挑战。在数据准备阶段,需解决数据集成、标注、选择等问题,还需应对大模型存在的知识更新慢、幻觉、训练成本高等痛点;在模型训练与推理阶段,面临图神经网络中邻居聚合效率低、卷积操作维度优化平衡计算量与成本、KV缓存内存有限、数据迁移耗时及模型可解释性差等问题。

随后,陈教授介绍了团队针对上述挑战的研究成果与优化方法。在数据选择与更新方面,提出基于buffer的优化策略,通过核心集选择(用10%数据达到100%数据的训练效果,还能减少过拟合)和贪心算法解决NP难的集合覆盖问题,保证误差可控;在训练效率提升方面,提出TGN训练加速方法,通过缓存并复用中间结果减少重复计算,在GNN中筛选有影响力节点减少无用聚合,在大规模图训练中通过状态感知通信避免冗余数据传输,节省74%-80%通信成本;在推理优化方面,针对KV缓存不足问题,提出混合缓存策略,结合先到先服务和随机调度,还通过存储KV对前一层的隐藏层结果,节省一半内存,提升请求处理量与首token生成速度;在模型可解释性方面,强调需保证解释客观、能区分不同类别且规模适中,团队在化学分析中实现了针对不同类别给出不同高评分结构解释的效果,同时提及在向量数据库、AI驱动索引等领域的探索。

最后,陈教授总结了报告核心,梳理了从数据重要性到技术挑战,再到具体优化方案的逻辑,展现了数据预处理在深度学习尤其是大模型应用中的关键价值。报告结束后,因时间限制未开展现场交流环节,教授也讲到有兴趣的同学可后续通过邮件或参与香港科技大学(广州)的论坛、会议进一步探讨。本次前沿秀报告在热烈掌声中圆满落幕。

第三十八期方班前沿秀报告圆满落幕。

整理:骆俊杰 梁唯新

校对:王乐老师 鲁辉老师 殷丽华老师

责任编辑:鲁辉老师